Tuning no Postgres utlizando View Materializada

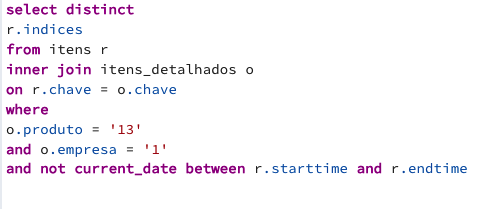

Fala pessoal, espero que estejam todos muito bem! Sei que faz algum tempo desde o último post, mas pretendo retomar as publicações a partir de agora. Para recomeçar com tudo, vamos falar sobre como um DBA do SQL Server conseguiu otimizar o desempenho no PostgreSQL. O desafio era otimizar a query abaixo: A query é relativamente simples, porém, o grande desafio está na cardinalidade. Estamos lidando com um alto volume de dados e uma modelagem N:N, o que tornou o tuning bastante desafiador. Após a execução do plano, pude observar alguns pontos. Criamos índices para aprimorar a consulta, mas mesmo assim, nada disso resultou em um desempenho aceitável para a query. Para a galera do SQL Server (assim como eu rs), podemos utilizar o comando: EXPLAIN (FORMAT JSON, VERBOSE, ANALYZE) no PgAdmin para visualizar o plano de execução de forma gráfica. Ufa, isso realmente facilitou minha vida. Foi então que comecei a analisar os dados e desmembrar a ...